He aquí por qué te recuerdas a Chatgpt ahora tomando un descanso

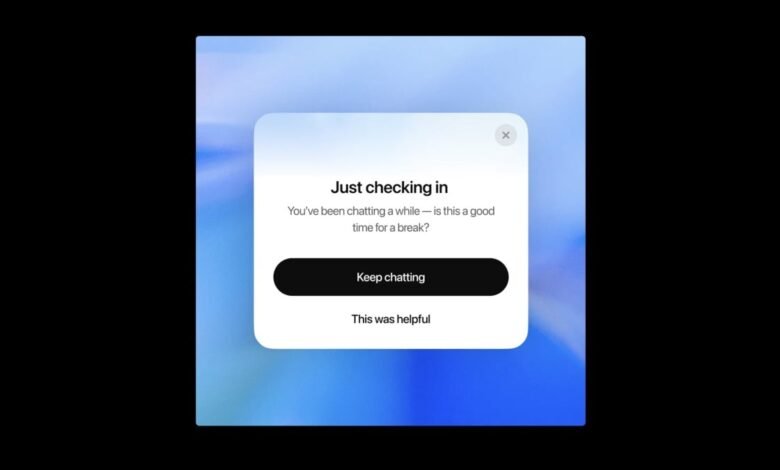

Si su rutina diaria incluye chatear con frecuencia con CHATGPT, puede sorprenderse por una nueva ventana emergente esta semana. Después de una larga conversación, se puede presentar con una ventana «simplemente verificar», con leer un mensaje: «Estabas hablando en algún momento, ¿es este el momento de pasar unas vacaciones?»

La ventana emergente le brinda la opción de «continuar charlando», o incluso elegir «esto fue útil». Dependiendo de su perspectiva, puede ver esto como un buen recordatorio para publicar la aplicación durante un período de tiempo, o una nota de concesión de que no sabe cómo limitar su tiempo usando chatbot.

No lo tomes personalmente-Openai puede parecer interesado en tus hábitos de uso con esta ventana emergente, pero la verdadera razón detrás del cambio es un poco más oscura que eso.

Chatgpt adicto

El recordatorio de este nuevo uso fue parte de un anuncio más grande que Openai el lunes, titulado «BAT»Lo que mejoramos chatgptEn la publicación, la compañía dice que aprecia cómo usa ChatGPT, y que si bien la compañía quiere usar el servicio, también ve el beneficio de usar el servicio. menos. Parte de esto a través de características como Agente de chatgptQue puede tomar medidas en su nombre, pero también por el tiempo que Hacer Elimine el chatgpt más efectivo y efectivo.

Todo esto es bueno y bueno: si OpenAi quiere trabajar para tener un chat de habitación útil para los usuarios en una pequeña parte del tiempo, que lo sea. Pero esto no simplemente proviene del deseo de hacer que los usuarios aceleren sus interacciones con ChatGPT; En cambio, es una respuesta directa a cómo ChatGPT es adicción, especialmente para las personas que dependen de Chatbot para obtener apoyo mental o emocional.

No necesita leer entre líneas en esto también. Para crédito de OpenAI, la compañía aborda directamente problemas serios que algunos de sus usuarios han enfrentado recientemente con ChatBot, incluida la actualización a principios de este año. Que hizo que el chat fuera una manera muy aceptable. Chatbots Tiendes a ser entusiasta y amigablePero la actualización del modelo 4O lo llevó muy lejos. ChatGPT confirmará que todas sus pensamientos, buenas, malas o terribles, son válidas. En los peores casos, el robot ignora los signos de ilusión y se alimenta directamente a la perspectiva de estos usuarios distorsionados.

Operai es reconocido directamente por la ocurrencia de esto, aunque la compañía cree que estos casos son «raros». Sin embargo, están atacando el problema directamente: además de estos recordatorios de tomar un descanso de ChatGPT, la compañía dice que está trabajando para mejorar los modelos para buscar signos de angustia, así como evitar responder problemas complejos o difíciles, como «¿Debo separarme con mi pareja?» Operai dice que está cooperando con expertos, médicos y profesionales médicos de varias maneras para lograr esto.

Todos debemos usar una inteligencia artificial un poco más baja

Es cierto que OpenAI quiere que uses menos chatgpt, y que reconocen activamente sus problemas y trabajan para abordarlo. Pero no creo que sea suficiente para confiar en Openai aquí. Lo que es en interés de la empresa no siempre estará allí para ti Mejor interés. En mi opinión, todos podemos aprovechar el retiro de la inteligencia artificial.

¿Qué piensas hasta ahora?

Dado que cada vez más personas recurren a los chatbots para obtener apoyo con el trabajo, las relaciones o la salud mental, es importante recordar que estas herramientas no son perfectas o incluso completamente entendidas. Como vimos con GPT-4O, los modelos de inteligencia artificial pueden ser defectuosos y decidir comenzar a alentar formas peligrosas de pensar. Los modelos de inteligencia artificial también pueden alucinacionesO, en otras palabras, haz las cosas por completo. Puede pensar que la información proporcionada por ChatBot es 100 % precisa, pero puede estar llena de errores o mentiras explícitas, ¿cómo está a menudo? ¿negociaciones?

La confianza en la inteligencia artificial con sus propias ideas personales también representa el riesgo de privacidad, A medida que compañías como OpenAi almacenan sus chatsViene con cualquier protección legal, un representante médico con licencia o un actor legal. Además, Los estudios emergentes indican Cuanto más confiamos en la inteligencia artificial, más dependemos de nuestras habilidades de pensamiento crítico. Aunque puede ser muy excesivo decir que la inteligencia artificial nos hace «estúpidos», me preocuparé por la cantidad de fortaleza mental que cooperamos en estos nuevos robots.

Los chatbots no son terapeutas autorizados; Tienden a fabricar asuntos; Tienen algunas protección de la privacidad. Incluso pueden alentar el pensamiento de la ilusión. Es genial que Operai quiera que use menos chatgpt, pero es posible que deseemos usar estas herramientas menos que eso.

Divulgación: la madre de Lifehacker, Zif Davis, presentó una demanda contra Operai en abril, su afirmación de que había violado los derechos de autor de Ziff Davis en la capacitación y la operación de sus sistemas de IA.